© Intel

Analizy |

Stała ewolucja prawa Moore’a

Ponad pół wieku od przedstawienia prawa Moore’a, nadal kształtuje ono krajobraz technologiczny. Dyrektor ds. technologii w firmie Intel, Mike Mayberry podzielił się swoimi przemyśleniami na ten temat.

Umarło prawo Moore’a — niech żyje prawo Moore’a! Prawo Moore’a stanowiło główny temat rozmów podczas tegorocznej konferencji na rzecz inicjatywy w zakresie rozwoju elektroniki (Electronics Resurgence Initiative, ERI) zorganizowanej przez Agencję Zaawansowanych Projektów Badawczych w Obszarze Obronności (DARPA).

Aby zrozumieć tę debatę, musimy najpierw uzgodnić, co oznacza prawo Moore’a.

W 1965 roku Gordon Moore zauważył, że dodanie kolejnych funkcji do układu scalonego sprawia, że koszt pojedynczej funkcji maleje. Pierwsza część tej obserwacji jest związana z gospodarką, a jej istota pozostaje niezmienna, chociaż zarówno technologia, jak i tempo wprowadzania zmian ewoluowały.

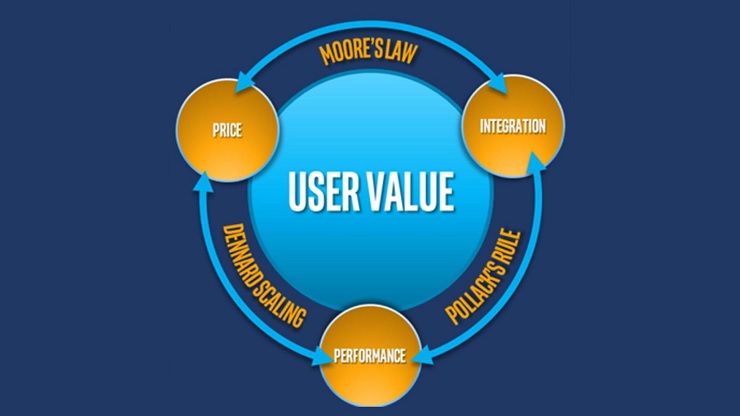

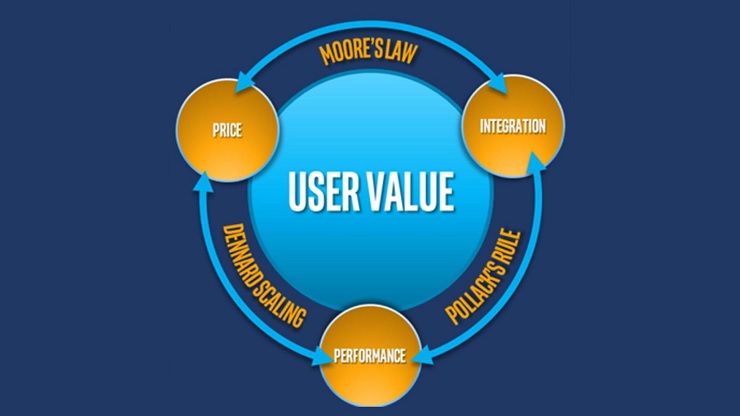

Spostrzeżenia Moore’a nie dotyczyły wydajności. To była domena Roberta Dennarda i Freda Pollacka. Dennard zaobserwował w 1974, że w miarę zmniejszania rozmiarów tranzystorów ich częstotliwość i moc rosły, o ile funkcje i napięcie zostały odpowiednio wyskalowane. Pollack z firmy Intel zauważył, że podwojenie złożoności mikroprocesora powodowało blisko półtorakrotny wzrost wydajności.

Opierając się na tych danych możemy skonstruować trójkąt wartości użytkownika, pokazujący zależności między ceną, integracją i wydajnością.

Co mają na myśli ci, którzy sądzą, że prawo Moore’a jest martwe? Takie osoby często uważają, że co najmniej jeden bok tego trójkąta nie ma zastosowania do dzisiejszej rzeczywistości, a nie, że gospodarczy aspekt prawa Moore’a jest nieaktualny – zauważa Mike Mayberry.

Po pierwsze, gdy użytkownicy narzekają, że częstotliwości rdzenia procesora nie rosną już tak szybko, jak w latach 90. XX wieku, tak naprawdę mówią o prawie Dennarda. Zasada Dennarda nigdy nie znalazła dokładnego odzwierciedlenia w rzeczywistości, ale w latach 90. byliśmy temu najbliżsi.

Po drugie użytkownikom wydaje się, że komputery wcale nie są coraz szybsze. Wiąże się to z obserwacją Pollacka, szczególnie w odniesieniu do procesora, ale nie uwzględnia problemów związanych z siecią lub pamięcią. Większość architektur opiera się obecnie na pamięci, a wiele codziennych zadań wykonujemy w sieci. Zbudowanie samego szybszego procesora, bez poświęcenia uwagi ograniczeniom związanym z pamięcią lub siecią, powoduje tylko przyrostowy wzrost wydajności.

Trzeci wątek debaty, chociaż nie dotyczy zaprezentowanego tu trójkąta, jest związany z gospodarką: koszt budowy najnowocześniejszych rozwiązań staje rośnie. Niektóre firmy nie wdrażają nowych narzędzi, bo są one za drogie, jednak oficjalna wersja brzmi, że „tak naprawdę ich nie potrzebują”.

Debata na ten temat trwa od początku XXI wieku. Jednocześnie technolodzy ignorują argumenty gospodarcze i pracują nad ciągłym postępem. Oto przykład postępu na przestrzeni 10 lat: zmniejszenie spersonalizowanego systemu wielkości mikrofalówki do rozmiarów dużej książki. Co więcej, nowy system jest wydajniejszy od starego! Takie oparte na integracji podejście sprzyja rozwojowi gospodarczemu, co stanowi sedno prawa Moore’a, a przy tym zapewnia stały skalowalny wzrost wydajności, mimo że zasada Dennarda już nie obowiązuje.

Po pierwsze, gdy użytkownicy narzekają, że częstotliwości rdzenia procesora nie rosną już tak szybko, jak w latach 90. XX wieku, tak naprawdę mówią o prawie Dennarda. Zasada Dennarda nigdy nie znalazła dokładnego odzwierciedlenia w rzeczywistości, ale w latach 90. byliśmy temu najbliżsi.

Po drugie użytkownikom wydaje się, że komputery wcale nie są coraz szybsze. Wiąże się to z obserwacją Pollacka, szczególnie w odniesieniu do procesora, ale nie uwzględnia problemów związanych z siecią lub pamięcią. Większość architektur opiera się obecnie na pamięci, a wiele codziennych zadań wykonujemy w sieci. Zbudowanie samego szybszego procesora, bez poświęcenia uwagi ograniczeniom związanym z pamięcią lub siecią, powoduje tylko przyrostowy wzrost wydajności.

Trzeci wątek debaty, chociaż nie dotyczy zaprezentowanego tu trójkąta, jest związany z gospodarką: koszt budowy najnowocześniejszych rozwiązań staje rośnie. Niektóre firmy nie wdrażają nowych narzędzi, bo są one za drogie, jednak oficjalna wersja brzmi, że „tak naprawdę ich nie potrzebują”.

Debata na ten temat trwa od początku XXI wieku. Jednocześnie technolodzy ignorują argumenty gospodarcze i pracują nad ciągłym postępem. Oto przykład postępu na przestrzeni 10 lat: zmniejszenie spersonalizowanego systemu wielkości mikrofalówki do rozmiarów dużej książki. Co więcej, nowy system jest wydajniejszy od starego! Takie oparte na integracji podejście sprzyja rozwojowi gospodarczemu, co stanowi sedno prawa Moore’a, a przy tym zapewnia stały skalowalny wzrost wydajności, mimo że zasada Dennarda już nie obowiązuje.

- Skalowanie CMOS nie jest jeszcze gotowe, jednak w miarę poprawy możliwości kontrolowania produkcji widzimy stały postęp. Fizyka nie ogranicza nas tak bardzo, jak zdolność do produkowania dużej liczby elementów z zachowaniem wysokiego stopnia precyzji. To trudne wyzwanie, ale mamy nadzieję mu sprostać – stwierdza Mayberry.

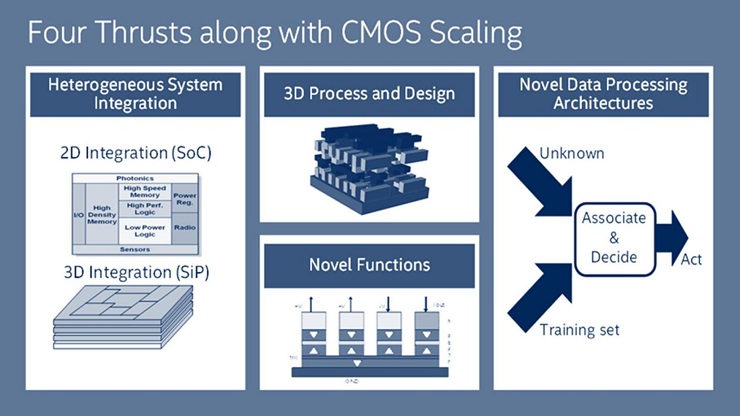

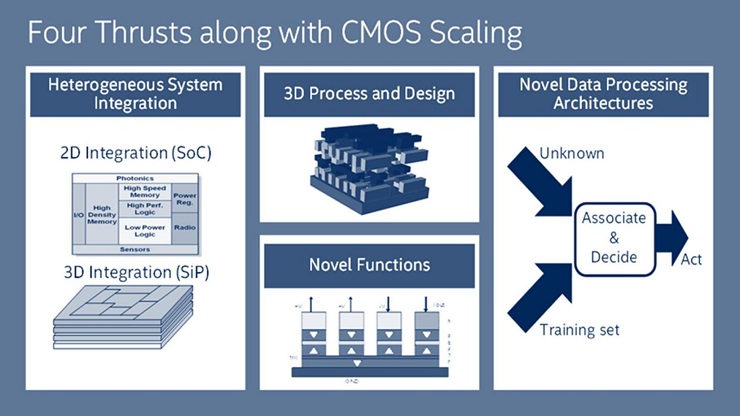

Jak zauważa Mike Mayberry, przeszliśmy na model 3D, zaczynając od Trigate (FinFET) z 22 nm węzłem, jednak jeszcze lepszym przykładem jest przedstawienie w maju 96-warstwowej pamięci flash NAND z limitem 4 bitów na komórkę, która jest w stanie pomieścić 1 terabit informacji na kość. To doskonały przykład ilustrujący zmierzch zasady Dennarda – kość zawiera coraz więcej funkcji, a dalsze skalowanie nie jest konieczne. Spodziewamy się, że z czasem układy logiczne również przesuną się w kierunku technologii 3D.

Szef ds. technologii Intela podkreśla też, że firma pracuje już nad kilkoma urządzeniami, takimi jak tunelowy tranzystor polowy i ferroelektryka, które mogą znacząco poprawić wydajność. Niestety nie są one prostym zamiennikiem technologii CMOS. Dlatego zamierzają zintegrować je w heterogeniczny sposób, np. jako warstwy, łącząc zalety skalowalnej technologii CMOS i nowatorskich funkcji tych nowych urządzeń.

- Skalowanie CMOS nie jest jeszcze gotowe, jednak w miarę poprawy możliwości kontrolowania produkcji widzimy stały postęp. Fizyka nie ogranicza nas tak bardzo, jak zdolność do produkowania dużej liczby elementów z zachowaniem wysokiego stopnia precyzji. To trudne wyzwanie, ale mamy nadzieję mu sprostać – stwierdza Mayberry.

Jak zauważa Mike Mayberry, przeszliśmy na model 3D, zaczynając od Trigate (FinFET) z 22 nm węzłem, jednak jeszcze lepszym przykładem jest przedstawienie w maju 96-warstwowej pamięci flash NAND z limitem 4 bitów na komórkę, która jest w stanie pomieścić 1 terabit informacji na kość. To doskonały przykład ilustrujący zmierzch zasady Dennarda – kość zawiera coraz więcej funkcji, a dalsze skalowanie nie jest konieczne. Spodziewamy się, że z czasem układy logiczne również przesuną się w kierunku technologii 3D.

Szef ds. technologii Intela podkreśla też, że firma pracuje już nad kilkoma urządzeniami, takimi jak tunelowy tranzystor polowy i ferroelektryka, które mogą znacząco poprawić wydajność. Niestety nie są one prostym zamiennikiem technologii CMOS. Dlatego zamierzają zintegrować je w heterogeniczny sposób, np. jako warstwy, łącząc zalety skalowalnej technologii CMOS i nowatorskich funkcji tych nowych urządzeń.

Ponieważ stale rośnie ilość i liczba rodzajów danych, potrzebna jest szybka integracja nowatorskich specjalistycznych architektur z nowym światem danych. Realizacja tego zadania z wykorzystaniem podejścia heterogenicznego będzie nie tylko szybsza, ale pozwoli też na wykorzystanie układów różnych zespołów.

Nowe architektury, które łączą pamięć i moc obliczeniową, są przykładem przetwarzania danych wykraczającego poza zasadę Pollacka. Jedną z takich architektur jest Loihi, neuromorficzny układ badawczy firmy Intel. Obciążenia sztucznej inteligencji korzystają z innych szablonów dostępu do pamięci i w związku z tym mogą używać do przetwarzania danych innych architektur niż tradycyjne oprogramowanie.

Podsumowując, Mayberry spodziewa się, że gospodarcze korzyści wynikające z prawa Moore’a nadal będą obowiązywać, nawet jeśli komponenty tezy wyglądają zupełnie inaczej niż w czasach Moore’a.

Źródło: © Intel, autor: Mike Mayberry, dyrektor ds. technologii w firmie Intel

Ponieważ stale rośnie ilość i liczba rodzajów danych, potrzebna jest szybka integracja nowatorskich specjalistycznych architektur z nowym światem danych. Realizacja tego zadania z wykorzystaniem podejścia heterogenicznego będzie nie tylko szybsza, ale pozwoli też na wykorzystanie układów różnych zespołów.

Nowe architektury, które łączą pamięć i moc obliczeniową, są przykładem przetwarzania danych wykraczającego poza zasadę Pollacka. Jedną z takich architektur jest Loihi, neuromorficzny układ badawczy firmy Intel. Obciążenia sztucznej inteligencji korzystają z innych szablonów dostępu do pamięci i w związku z tym mogą używać do przetwarzania danych innych architektur niż tradycyjne oprogramowanie.

Podsumowując, Mayberry spodziewa się, że gospodarcze korzyści wynikające z prawa Moore’a nadal będą obowiązywać, nawet jeśli komponenty tezy wyglądają zupełnie inaczej niż w czasach Moore’a.

Źródło: © Intel, autor: Mike Mayberry, dyrektor ds. technologii w firmie Intel

Po pierwsze, gdy użytkownicy narzekają, że częstotliwości rdzenia procesora nie rosną już tak szybko, jak w latach 90. XX wieku, tak naprawdę mówią o prawie Dennarda. Zasada Dennarda nigdy nie znalazła dokładnego odzwierciedlenia w rzeczywistości, ale w latach 90. byliśmy temu najbliżsi.

Po drugie użytkownikom wydaje się, że komputery wcale nie są coraz szybsze. Wiąże się to z obserwacją Pollacka, szczególnie w odniesieniu do procesora, ale nie uwzględnia problemów związanych z siecią lub pamięcią. Większość architektur opiera się obecnie na pamięci, a wiele codziennych zadań wykonujemy w sieci. Zbudowanie samego szybszego procesora, bez poświęcenia uwagi ograniczeniom związanym z pamięcią lub siecią, powoduje tylko przyrostowy wzrost wydajności.

Trzeci wątek debaty, chociaż nie dotyczy zaprezentowanego tu trójkąta, jest związany z gospodarką: koszt budowy najnowocześniejszych rozwiązań staje rośnie. Niektóre firmy nie wdrażają nowych narzędzi, bo są one za drogie, jednak oficjalna wersja brzmi, że „tak naprawdę ich nie potrzebują”.

Debata na ten temat trwa od początku XXI wieku. Jednocześnie technolodzy ignorują argumenty gospodarcze i pracują nad ciągłym postępem. Oto przykład postępu na przestrzeni 10 lat: zmniejszenie spersonalizowanego systemu wielkości mikrofalówki do rozmiarów dużej książki. Co więcej, nowy system jest wydajniejszy od starego! Takie oparte na integracji podejście sprzyja rozwojowi gospodarczemu, co stanowi sedno prawa Moore’a, a przy tym zapewnia stały skalowalny wzrost wydajności, mimo że zasada Dennarda już nie obowiązuje.

Po pierwsze, gdy użytkownicy narzekają, że częstotliwości rdzenia procesora nie rosną już tak szybko, jak w latach 90. XX wieku, tak naprawdę mówią o prawie Dennarda. Zasada Dennarda nigdy nie znalazła dokładnego odzwierciedlenia w rzeczywistości, ale w latach 90. byliśmy temu najbliżsi.

Po drugie użytkownikom wydaje się, że komputery wcale nie są coraz szybsze. Wiąże się to z obserwacją Pollacka, szczególnie w odniesieniu do procesora, ale nie uwzględnia problemów związanych z siecią lub pamięcią. Większość architektur opiera się obecnie na pamięci, a wiele codziennych zadań wykonujemy w sieci. Zbudowanie samego szybszego procesora, bez poświęcenia uwagi ograniczeniom związanym z pamięcią lub siecią, powoduje tylko przyrostowy wzrost wydajności.

Trzeci wątek debaty, chociaż nie dotyczy zaprezentowanego tu trójkąta, jest związany z gospodarką: koszt budowy najnowocześniejszych rozwiązań staje rośnie. Niektóre firmy nie wdrażają nowych narzędzi, bo są one za drogie, jednak oficjalna wersja brzmi, że „tak naprawdę ich nie potrzebują”.

Debata na ten temat trwa od początku XXI wieku. Jednocześnie technolodzy ignorują argumenty gospodarcze i pracują nad ciągłym postępem. Oto przykład postępu na przestrzeni 10 lat: zmniejszenie spersonalizowanego systemu wielkości mikrofalówki do rozmiarów dużej książki. Co więcej, nowy system jest wydajniejszy od starego! Takie oparte na integracji podejście sprzyja rozwojowi gospodarczemu, co stanowi sedno prawa Moore’a, a przy tym zapewnia stały skalowalny wzrost wydajności, mimo że zasada Dennarda już nie obowiązuje.

- Skalowanie CMOS nie jest jeszcze gotowe, jednak w miarę poprawy możliwości kontrolowania produkcji widzimy stały postęp. Fizyka nie ogranicza nas tak bardzo, jak zdolność do produkowania dużej liczby elementów z zachowaniem wysokiego stopnia precyzji. To trudne wyzwanie, ale mamy nadzieję mu sprostać – stwierdza Mayberry.

Jak zauważa Mike Mayberry, przeszliśmy na model 3D, zaczynając od Trigate (FinFET) z 22 nm węzłem, jednak jeszcze lepszym przykładem jest przedstawienie w maju 96-warstwowej pamięci flash NAND z limitem 4 bitów na komórkę, która jest w stanie pomieścić 1 terabit informacji na kość. To doskonały przykład ilustrujący zmierzch zasady Dennarda – kość zawiera coraz więcej funkcji, a dalsze skalowanie nie jest konieczne. Spodziewamy się, że z czasem układy logiczne również przesuną się w kierunku technologii 3D.

Szef ds. technologii Intela podkreśla też, że firma pracuje już nad kilkoma urządzeniami, takimi jak tunelowy tranzystor polowy i ferroelektryka, które mogą znacząco poprawić wydajność. Niestety nie są one prostym zamiennikiem technologii CMOS. Dlatego zamierzają zintegrować je w heterogeniczny sposób, np. jako warstwy, łącząc zalety skalowalnej technologii CMOS i nowatorskich funkcji tych nowych urządzeń.

- Skalowanie CMOS nie jest jeszcze gotowe, jednak w miarę poprawy możliwości kontrolowania produkcji widzimy stały postęp. Fizyka nie ogranicza nas tak bardzo, jak zdolność do produkowania dużej liczby elementów z zachowaniem wysokiego stopnia precyzji. To trudne wyzwanie, ale mamy nadzieję mu sprostać – stwierdza Mayberry.

Jak zauważa Mike Mayberry, przeszliśmy na model 3D, zaczynając od Trigate (FinFET) z 22 nm węzłem, jednak jeszcze lepszym przykładem jest przedstawienie w maju 96-warstwowej pamięci flash NAND z limitem 4 bitów na komórkę, która jest w stanie pomieścić 1 terabit informacji na kość. To doskonały przykład ilustrujący zmierzch zasady Dennarda – kość zawiera coraz więcej funkcji, a dalsze skalowanie nie jest konieczne. Spodziewamy się, że z czasem układy logiczne również przesuną się w kierunku technologii 3D.

Szef ds. technologii Intela podkreśla też, że firma pracuje już nad kilkoma urządzeniami, takimi jak tunelowy tranzystor polowy i ferroelektryka, które mogą znacząco poprawić wydajność. Niestety nie są one prostym zamiennikiem technologii CMOS. Dlatego zamierzają zintegrować je w heterogeniczny sposób, np. jako warstwy, łącząc zalety skalowalnej technologii CMOS i nowatorskich funkcji tych nowych urządzeń.

Ponieważ stale rośnie ilość i liczba rodzajów danych, potrzebna jest szybka integracja nowatorskich specjalistycznych architektur z nowym światem danych. Realizacja tego zadania z wykorzystaniem podejścia heterogenicznego będzie nie tylko szybsza, ale pozwoli też na wykorzystanie układów różnych zespołów.

Nowe architektury, które łączą pamięć i moc obliczeniową, są przykładem przetwarzania danych wykraczającego poza zasadę Pollacka. Jedną z takich architektur jest Loihi, neuromorficzny układ badawczy firmy Intel. Obciążenia sztucznej inteligencji korzystają z innych szablonów dostępu do pamięci i w związku z tym mogą używać do przetwarzania danych innych architektur niż tradycyjne oprogramowanie.

Podsumowując, Mayberry spodziewa się, że gospodarcze korzyści wynikające z prawa Moore’a nadal będą obowiązywać, nawet jeśli komponenty tezy wyglądają zupełnie inaczej niż w czasach Moore’a.

Źródło: © Intel, autor: Mike Mayberry, dyrektor ds. technologii w firmie Intel

Ponieważ stale rośnie ilość i liczba rodzajów danych, potrzebna jest szybka integracja nowatorskich specjalistycznych architektur z nowym światem danych. Realizacja tego zadania z wykorzystaniem podejścia heterogenicznego będzie nie tylko szybsza, ale pozwoli też na wykorzystanie układów różnych zespołów.

Nowe architektury, które łączą pamięć i moc obliczeniową, są przykładem przetwarzania danych wykraczającego poza zasadę Pollacka. Jedną z takich architektur jest Loihi, neuromorficzny układ badawczy firmy Intel. Obciążenia sztucznej inteligencji korzystają z innych szablonów dostępu do pamięci i w związku z tym mogą używać do przetwarzania danych innych architektur niż tradycyjne oprogramowanie.

Podsumowując, Mayberry spodziewa się, że gospodarcze korzyści wynikające z prawa Moore’a nadal będą obowiązywać, nawet jeśli komponenty tezy wyglądają zupełnie inaczej niż w czasach Moore’a.

Źródło: © Intel, autor: Mike Mayberry, dyrektor ds. technologii w firmie Intel